![]()

Цель этой статьи — объяснить, что нынешний подход к разработкам ИИИ на основе GPT изначально ошибочен и порочен, поскольку игнорирует основные понятия об интеллекте (Intelligence) и обработке информации (Information processing). Статья поддерживает общее мнение о том, что неограниченное и свободное распространение неправильно разработанных ИИИ на основе GPT представляет собой угрозу человеческому сообществу, подобную угрозе неосторожного обращения с вирусами при разработке и исследованиях бактериологического оружия.

Инструменты Искусственного Интеллекта (BICA и GPT):

Соратники или соперники?

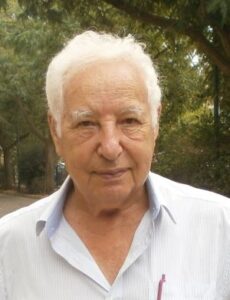

Эммануил Диамант

Аннотация: BICA*AI — это хорошо себя зарекомендовавшее долгосрочное научно-исследовательское предприятие, направленное на создание вычислительных структур, имитирующих Искусственный Интеллект (ИИ) Человеческого Уровня. Недавно, и совершенно неожиданно, рядом с ним появился еще один претендент на эти же цели — Инструмент Искусственного Интеллекта (ИИИ) на основе GPT (Воспроизводимый Предварительно Тренированный Преобразователь), предназначенный для имитации разговора человека с компьютером на удобном для пользователя естественном человеческом языке. Как заявляют его разработчики, это устройство имеет все признаки Общего ИИ (General Artificial Intelligence — GAI). Однако, после взволнованного и радостного приема новичка, вдруг оказалось, что он не всегда ведёт себя должным образом — возвращает неправильные и вводящие в заблуждение ответы, врёт и дезинформирует. Эта проблема вызвала волну общественных протестов и просьб немедленно приостановить дальнейшее распространение устройства. С другой стороны, разработчики устройства утверждают, что все эти недостатки носят временный характер, и очень скоро продукт обретёт свои заявленные качества. Нет, нет — никогда ничего такого не произойдёт! Цель этой статьи — объяснить, что нынешний подход к разработкам ИИИ на основе GPT изначально ошибочен и порочен, поскольку игнорирует основные понятия об интеллекте (Intelligence) и обработке информации (Information processing). Статья поддерживает общее мнение о том, что неограниченное и свободное распространение неправильно разработанных ИИИ на основе GPT представляет собой угрозу человеческому сообществу, подобную угрозе неосторожного обращения с вирусами при разработке и исследованиях бактериологического оружия.

Аннотация: BICA*AI — это хорошо себя зарекомендовавшее долгосрочное научно-исследовательское предприятие, направленное на создание вычислительных структур, имитирующих Искусственный Интеллект (ИИ) Человеческого Уровня. Недавно, и совершенно неожиданно, рядом с ним появился еще один претендент на эти же цели — Инструмент Искусственного Интеллекта (ИИИ) на основе GPT (Воспроизводимый Предварительно Тренированный Преобразователь), предназначенный для имитации разговора человека с компьютером на удобном для пользователя естественном человеческом языке. Как заявляют его разработчики, это устройство имеет все признаки Общего ИИ (General Artificial Intelligence — GAI). Однако, после взволнованного и радостного приема новичка, вдруг оказалось, что он не всегда ведёт себя должным образом — возвращает неправильные и вводящие в заблуждение ответы, врёт и дезинформирует. Эта проблема вызвала волну общественных протестов и просьб немедленно приостановить дальнейшее распространение устройства. С другой стороны, разработчики устройства утверждают, что все эти недостатки носят временный характер, и очень скоро продукт обретёт свои заявленные качества. Нет, нет — никогда ничего такого не произойдёт! Цель этой статьи — объяснить, что нынешний подход к разработкам ИИИ на основе GPT изначально ошибочен и порочен, поскольку игнорирует основные понятия об интеллекте (Intelligence) и обработке информации (Information processing). Статья поддерживает общее мнение о том, что неограниченное и свободное распространение неправильно разработанных ИИИ на основе GPT представляет собой угрозу человеческому сообществу, подобную угрозе неосторожного обращения с вирусами при разработке и исследованиях бактериологического оружия.

Ключевые слова: BICA*AI, GPT-based tools, General AI.

- Введение

BICA*AI — аббревиатура, которая расшифровывается как «Биологически вдохновленные когнитивные архитектуры для искусственного интеллекта», является хорошо зарекомендовавшим себя многолетним (с 2005 г.) научно-исследовательским предприятием, направленным на создание вычислительных архитектур человеческого интеллекта, [1]. «Конечная цель исследований в области когнитивных архитектур — это смоделировать человеческий разум, что в конечном итоге позволит нам создать искусственный интеллект человеческого уровня. С этой целью когнитивные архитектуры пытаются предоставить доказательства того, какие конкретные механизмы соучаствуют в обеспечении разумного поведения и, таким образом, вносят свой вклад в науку о сознании», [2].

Generative AI or GPT — что расшифровывается как «Воспроизводимый предварительно обученный преобразователь» — это недавно созданный инструмент Искусственного Интеллекта (ИИ), предназначенный для имитации разговора компьютера с его пользователем (на естественном языке пользователя) и имитации поведения человека в качестве собеседника, [3]. Модели GPT обучаются на огромных объемах текстовых данных, взятых из Интернета, и способны генерировать ответы, очень похожие на человеческий текст. Первоначально разработанные для задач Natural Language Processing (NLP), преобразователи были адаптированы для различных задач зрения (классификация изображений, обнаружение объектов, генерация изображений и обработка видео), приложений, связанных со звуком (распознавание речи, синтез речи, улучшение речи, генерация музыки) и различные мультимодальные сценарии (визуальный ответ на вопрос, визуальное рассуждение на основе здравого смысла, генерация титров, перевод речи в текст и генерация текста в изображение), [4]. Основная модель GPT, разработанная OpenAI, впоследствии дополнялась все более и более сложными версиями, такими как GPT-2 в 2019 году и GPT-3 в 2020 году. В декабре 2022 года OpenAI запустила бесплатную предварительную версию модели ChatGPT, нового AI. инструмент на базе версии модели GPT-3.5. 14 марта 2023 г. OpenAI выпустила GPT-4 как в качестве отдельного приложения, так и в качестве функции ChatGPT [5]. По данным OpenAI, за первые пять дней на превью новой модели зарегистрировалось более миллиона человек. Как сообщает анонимный источник (цитируется Reuters в декабре 2022 г.), OpenAI прогнозирует доход в размере 200 миллионов долларов в 2023 году и доход в 1 миллиард долларов в 2024 году, [5]. Вдохновленные успехом OpenAI, другие разработчики GPT запустили свои собственные продукты: Amazon, Google, Microsoft, Baidu, GitHub, Meta, Apple, IBM, Nvidia и другие создали свои собственные продукты на основе GPT и выставили их на рынок, [6].

Из этого краткого описания достижений BICA и GPT-4 совершенно ясно, что продукты на основе GPT занимают гораздо более привилегированное положение в глазах разработчиков и пользователей инструментов искусственного интеллекта человеческого уровня.

Однако при ближайшем рассмотрении оказывается, что позиции ИИ-инструментов на основе GPT не так уж прекрасны, как это может показаться на первый взгляд.

Несмотря на общепризнанный успех в создании искусственных устройств, имитирующих человеческую способность общаться посредством устного или письменного разговора, устройства на основе GPT доказали свою потенциальную опасность для своих пользователей, [7], [8], [9]. Согласно многим публикациям, GPT — это большая языковая модель, использующая глубокое обучение (Deep Learning) для создания человекоподобного текста. Или, точнее, это вычислительная система, предназначенная для генерации последовательности слов, кода или других данных, и запускаемая введением начального слова или фразы, называемых подсказкой (prompt), [10]. При определении последовательности слов она просто предсказывает следующее слово на основе статистических корреляций в обучающих данных и подсказках [9] Поскольку система видит только формальные, статистические связи между словами, она не понимает значения слов, не понимает их семантику. Поэтому GPT еще называют «стохастическим попугаем», случайным образом сшивающим слова без привязки к их смыслу или значению, [8].

Как следствие, из этого вытекают все остальные отрицательные качества системы — модель наследует систематические ошибки и ошибки в обучающих данных, модель очень чувствительна к формулировке подсказок. [11], ее ответы необъяснимы для пользователей, ее результаты не могут быть проверены или подтверждены, пользователи не могут определить достоверность результатов модели или всё это просто её «вымысел», [9]. С другой стороны, модель дает очень связные, естественно звучащие и похожие на человеческую речь ответы, которые пользователи находят убедительными и с готовностью доверяют им, даже если они неточны, [9]. В то же время система работает исключительно быстро, очень удобна для пользователя, отвечает на подсказки на естественном языке и практически не требует обучения пользователя, [8].

Из вышесказанного становится понятно, что системы GPT могут представлять серьезную опасность для общества и человечества. Понимая это и стремясь к конкретным действиям по устранению этих опасностей, несколько ведущих исследователей ИИ, а также ряд людей, работающих в компаниях, участвующих в гонке ИИ, подписали открытое письмо с призывом к шестимесячной паузе в обучении и создании систем ИИ, более мощных, чем GPT-4. [12].

В письме, опубликованном 30 марта 2023 года, говорится, что «в последние месяцы лаборатории искусственного интеллекта застряли в неконтролируемой гонке по разработке и развертыванию все более мощных систем цифрового разума». [13]. Более 1300 человек, в том числе Илон Маск и Стив Возняк, подписали это письмо с просьбой ко всем инженерам прекратить немедленную разработку ИИ за пределами GPT-4 на 6 месяцев из-за страха «потерять контроль». [13].

В ответ на этот призыв, 17 мая 2023 года подкомитет Судебного комитета Сената США провел слушание на тему «Надзор за ИИ: правила для искусственного интеллекта». [14]. Аналогичные меры административного контроля и административного порядка приняты парламентскими комиссиями Евросоюза, Великобритании, Японии и других стран (более подробный отчет о действиях многих стран в этом направлении можно найти в [15]).

В то же самое время, проблемой остается то, что эти меры административного контроля игнорируют научно-технические аспекты проблемы создания систем ИИ. Парламентские комиссии этими вопросами не занимаются, справедливо заявляя, что это не входит в их компетенцию.

При этом организации, занимающиеся созданием GPT систем, уверенно заявляют, что уже достигли уровня General Intelligence. Именно это утверждает Microsoft в своей недавней публикации: «ее (новую разработку) можно с полным основанием рассматривать как раннюю (но все еще неполную) версию системы общего искусственного интеллекта (AGI)», [16].

Простите, но это неправда! Бесконтрольное использование систем, создатели которых утверждают, что они уже достигли уровня Общего Разума, может быть только ещё более опасно для общества. Потому что широкая общественность некомпетентна в этих вопросах. А компетентные в этих вопросах ученые и исследователи утверждают, что до уровня Общего Разума нам еще очень далеко. И главная причина этого в том, что сегодня мы вообще не знаем, что такое Интеллект, и что такое когнитивные способности мозга.

Christopher Koch: «AGI плохо определен, потому что мы не знаем, как определить интеллект. Потому что мы этого не понимаем…», [17].

Luciano Floridi: Языковая модель GPT «не имеет ничего общего с интеллектом, сознанием,

семантикой, релевантностью, человеческим опытом и осознанностью в целом», [10].

Я намеренно привожу здесь цитаты из Кристофера Коха и Лучиано Флориди — Кристоф Кох, главный научный сотрудник программы Mindscope в Сиэтлском институте Аллена. У него есть опыт как в области искусственного интеллекта, так и в нейробиологии, он является автором трех книг о сознании, а также сотен статей на эту тему, в том числе статей для IEEE Spectrum и Scientific American, [17]. Лучиано Флориди — профессор философии и этики информации в Оксфордском университете, наиболее известный своими работами по философии информации и информационной этике. По данным Scopus, он был самым цитируемым из ныне живущих философов в мире в 2020 году, [18].

Поэтому, еще раз:

Кристофер Кох: «AGI плохо определен, потому что мы не знаем, как определить интеллект. Потому что мы этого не понимаем…», [17].

Лучиано Флориди: Языковая модель GPT «не имеет ничего общего с интеллектом, сознанием, семантикой, релевантностью, человеческим опытом и осознанностью в целом», [10].

Их мнения резко расходятся с мнением других выдающихся исследователей в области ИИ, так называемых «отцов-основателей» ИИ — Яна ЛеКуна [19], Джеффри Хинтона [20], Родни Брукса [21] и других, которые обеспокоены в основном социальными опасностями, связанными с неконтролируемым использованием инструментов ИИ на основе GPT. В их последних публикациях нет ни слова о технической или научной стороне вопроса.

Я намеренно привожу здесь цитаты Кристофера Коха и Лучиано Флориди, потому что их взгляды безоговорочно поддерживают мои собственные взгляды на предмет нашего обсуждения (и на исследования и разработки в области BICA*AI).

В течение последних лет я неоднократно излагал свою точку зрения по критически важным вопросам Intelligence and Information, которые обычно упускаются из виду в современных исследованиях ИИ. Заинтересованные читатели могут найти соответствующие статьи в списке литературы — [22], [23], [24], [25], [26], [27]. Но для последовательности нашего обсуждения я приведу здесь краткое резюме этих идей, изложенных когда-то в моих публикациях.

- Что такое Интеллект (Intelligence)?

Существует широко распространенное мнение, что человеческий интеллект нельзя определить как отдельную черту или как общий интеллект. Теории множественного интеллекта неуклонно привлекают всеобщее внимание. Однако чаще всего Интеллект воспринимается как обобщающий термин, который охватывает (интегрирует) множество когнитивных способностей человека (ощущать, воспринимать, интерпретировать окружающую среду, распознавать, классифицировать, строить планы, решать проблемы, предсказывать будущие ситуации, принимать решения и выбирать из альтернатив, учиться, запоминать и т. д.), которые в совокупности производят эффект интеллекта [26].

Еще одно распространенное мнение состоит в том, что все когнитивные способности человека являются продуктом деятельности человеческого мозга. Мозг, как это сегодня принято считать, занят обработкой информации. Поэтому, мы берём на себя смелость утверждать, что интеллект — это продукт (результат) обработки информации в человеческом мозге. В самом общем смысле: Интеллект — это способность обрабатывать информацию, [27]. В такой форме это определение применимо ко всем живым существам, а также и к искусственным конструкциям, созданным человеком.

- В таком случае: Что же такое Информация (Information)?

Хотя термин «информация» широко распространен и широко используется сегодня, никто на самом деле не знает, что он означает и для чего он, собственно говоря, предназначен.

Понятие «информация» впервые было введено Шенноном в 1948 году. Затем к этой задаче присоединились другие ученые — Колмогоров, Фишер, Хаитин. Однако ни один из них не был готов дать определение тому, что можно было бы назвать «информацией». Они были заняты «мерой информации». Этого было достаточно для повышения производительности и надежности систем технической связи, что в тот момент имело первостепенное значение.

В современных науках потребности связи не могут сводиться только к оптимизации технических параметров системы. Семантические аспекты сообщения имеют первостепенное значение и, следовательно, должны быть чётко определены.

В соответствии с духом этих требований, я разработал своё собственное определение информации. (Заинтересованные читатели могут обратиться к ссылкам [25], [28], [29]).

Мое определение информации сегодня звучит так:

«Информация — это лингвистическое описание структур, наблюдаемых в определённом массиве данных».

В наборе данных отдельные элементы данных распределены не случайным образом, а в силу сходства их физических параметров естественным образом группируются в какие-то кластеры или клики. Я предлагаю называть эти кластеры первичными или физическими структурами данных.

В глазах внешнего наблюдателя эти первичные структуры данных организуются в более крупные и сложные агломерации, которые я предлагаю называть вторичными структурами данных.

Эти вторичные структуры отражают взгляд наблюдателя на группировку первичных структур данных, и поэтому их можно назвать осмысленными или семантическими структурами данных.

В то время как формирование первичных (физических) структур данных определяется объективными (природными, физическими) свойствами данных, последующее формирование вторичных (семантических) структур данных представляет собой субъективный процесс, управляемый условностями и привычками наблюдателя (или взаимным согласием группы наблюдателей).

Как было сказано выше, описание структур, наблюдаемых в наборе данных, должно называться «Информация». В связи с этим, следует различать два вида информации — физическую информацию и семантическую информацию.

Оба являются языковыми описаниями; однако физическая информация может быть описана с помощью множества языков (вспомним, что математика — это тоже язык), а семантическая информация может быть описана только с использованием естественного языка наблюдателя. (Подробнее см. [25]).

Обработка информации осуществляется иерархически, смысловая информация более низкого уровня передается на следующий более высокий уровень, где она становится частью структуры более высокой сложности. Эта агломерация осуществляется согласно субъективным правилам, зафиксированным в прототипной (референтной) структуре, которая называется памятью наблюдателя, и которая хранится в теле нейрона.

Важным следствием вышеприведенного определения информации является понимание того, что информационные описания всегда материализуются в виде набора слов, фрагмента текста, нарратива. В связи с этим следует сделать важное замечание — в биологических системах эти текстовые последовательности записываются буквами нуклеотидов и знаками аминокислот.

Это превращает информацию в физическую сущность, в «вещь» со своим весом, длиной и другими физическими параметрами. Для целей нашего обсуждения это чрезвычайно важное замечание.

Итак, резюмируя сказанное: Мозг обрабатывает информацию. Нейроны являются функциональными элементами, которые выполняют возложенные на них обязанности. Несмотря на свою дискретную структуру, нейроны не являются отдельными функциональными единицами — успешная обработка информации требует тесного сотрудничества между собой многих соучастников. По этой причине нейроны связаны в сеть, в которой они общаются друг с другом, передавая, обменивая, изменяя — одним словом — совместно обрабатывая информацию.

- GPT ИИИ в свете обработки информации

Как уже было сказано выше, Интеллект — это продукт обработки Информации, где Информация — это лингвистическое описание наблюдаемых структур данных. Основная часть обработки информации в мозгу — это обработка семантической информации.

В связи с этим, опора GPT реализаций на большие языковые модели (Large Language Models — LLM) кажется естественной и оправданной. (Потому что семантическая информация — это лингвистическое описание, текст, нарратив).

Но более пристальный взгляд на парадигмы LLM показывает, что лингвистические компоненты в обучающем наборе моделей LLM выглядят, как набор преднамеренно разбитых на небольшие фрагменты слов, называемых токенами или параметрами модели. Размер параметров модели постоянно увеличивается — GPT-4 представляет собой модель с примерно 600 миллиардами параметров (некоторые предполагают, что их триллион). Более ранние модели (GPT-3/3.5) имели около 185 миллиардов.

В таком случае нельзя говорить о языковой модели, это больше похоже на статистическую модель данных. Именно так это и утверждается в соответствующей литературе — «Эти статистические модели необходимо обучать на больших объемах данных для получения соответствующих результатов» [10].

Механизмы глубокого обучения (машинного обучения), (Deep Learning (DL) and Machine Learning (ML) в английских текстах), используемые для обучения LLM, также могут быть ценным аргументом в нашем обсуждении — принципы машинного обучения применимы только к анализу и обнаружению структур данных (data patterns).

Описание структур данных (data patterns) называется физической информацией. Интеллект, как вы помните, занят обработкой семантической информации! Следовательно, мы можем сделать вывод, что нейронные сети ML годятся только для обработки физической информации, а не для обработки семантической информации, которая требуется для интеллекта.

Принцип «черного ящика» (Black Box), реализуемый в больших языковых моделях (LLMs), а также в любых других проектах, основанных на парадигме искусственной нейронной сети, не может быть внезапно отменен, улучшен или превращен в модель объяснимой нейронной сети. Описания физической информации, (отражающие структуру данных), не могут быть мгновенно преобразованы в описания семантической информации, то есть в лингвистическое описание, фрагмент текста, языковой образец. (Это то, на что, по утверждениям создателей, способны устройства с искусственным интеллектом на основе GPT).

Еще одно популярное и ложное утверждение состоит в том, что инструменты искусственного интеллекта на основе GPT можно считать близкими к достижению Общего ИИ (General AI, GAI). Опять же, это популярное и широко распространенное заблуждение. Обработка семантической информации осуществляется по правилам, сохраняемым в качестве эталонного прототипа (сохраняемой в памяти нейрона) семантической структуры текущего уровня. Эти правила, эти воспоминания — частная собственность наблюдателя. То есть семантическая обработка информации всегда субъективна. То есть идея Общего Разума неверна и не может быть реализована ни в какой естественной или искусственной модели. Множественный интеллект (только что упомянутый выше), являющийся композицией нескольких различных структур обработки субъективной семантической информации, можно рассматривать как наиболее близкую реализацию особенностей будущего искусственного интеллекта человеческого уровня.

- Некоторые заключительные примечания

Ажиотаж вокруг инструментов GPT AI не утихает. Но цель этой статьи не в том, чтобы принять участие в продолжающейся дискуссии, не в том, чтобы прославить или осудить достоинства или недостатки инструментов генеративного ИИ. Я пытаюсь сосредоточиться на технической стороне истории и проанализировать технические реалии (и мифы) инструментов GPT AI.

В этой связи, совершенно ясно, что зависимость инструментов GPT AI от методов глубокого обучения (Deep learning) и машинного обучения (Machine learning) отвергает любые претензии на связь инструментов GPT AI с обработкой естественного языка — NLP (Natural Language Processing) предполагает обработку семантики языка, обработку семантической информации, в то время как глубокое обучение занято обработкой синтаксиса языка (представленного огромным массивом исходных данных).

Принципы «черного ящика» (“Black box principles”), на которых строится эта обработка, обрекает ее результаты на непредсказуемость и ошибки. Именно это является источником сбоев и оплошностей всех инструментов GPT AI. Эти ошибки не могут быть устранены на дальнейших этапах обработки. Они являются фундаментными, базовыми, начальными характеристиками системы. И это уже с нею навсегда, навечно.

Многолетние (с 2015 по 2019) попытки DARPA создать объяснимые инструменты глубокого обучения (объяснимые инструменты искусственного интеллекта — XAI) потерпели полную неудачу, [30].

В этой связи, интересно будет вспомнить, что Али Рахими, лауреат премии NIPS 2017 года, в своей речи по случаю награждении заявил, что «текущая практика машинного обучения сродни «алхимии» [29].

Если машинное обучение — это алхимия, то что можно сказать тогда о сегодняшней концепции Интеллекта? (Интеллект, как вы теперь знаете, есть продукт обработки информации, семантической, а не физической информации, если вы запомнили).

Однако, разработчики устройств GPT AI настойчиво утверждают, что «Интеллект — это многогранное и неуловимое понятие, которое бросает вызов психологам, философам и специалистам по информатике. Не существует общепринятого определения интеллекта, но один аспект, который широко признается, заключается в том, что интеллект не ограничивается конкретной областью или задачей, а скорее охватывает широкий спектр когнитивных навыков и способностей». [16].

В продолжение только что приведенной цитаты, они (разработчики устройств GPT AI) настойчиво утверждают, что такой подход к Интеллекту согласуется с намерениями и воззрениями отцов-основателей AI, выраженными в «Предложении к летнему Дартмутскому исследовательскому проекту по искусственному интеллекту, 31 августа 1955 года». (Подписанному Джоном Маккарти, Марвином Л. Мински, Натанэлем Рочестером и Клодом Э. Шенноном).

Этот аргумент не кажется мне заслуживающим доверия. Особенно, если вспомнить, что взгляды отцов-основателей на проблемы AI были весьма размыты и туманны. Они не могли (в своё время) оценить всю сложность поставленной задачи (задачи определения Интеллекта) и внутренние противоречия между основными частями этого понятия. Вспомните историю о том, как Минский предложил нанять студента на время летних студенческих каникул, чтобы он разобрался с проблемой компьютерного зрения. (Проблема остается нерешенной по сей день), [26]. Вспомните, как Шеннон решительно отвергал малейшие попытки ввести понятие семантической информации: «Эти семантические аспекты коммуникации не имеют отношения к инженерной проблеме… Важно подчеркнуть с самого начала, что нас не интересует смысл или истинность сообщений; семантика лежит вне рамок математической теории информации» [31].

Несмотря на всё это, разработчики инструментов GPT AI гордо заявляют, что им удалось «дать предварительную оценку интеллекта GPT-4, что является трудной задачей ввиду отсутствия формального определения этого понятия, особенно для искусственных систем» [16]. Никаких признаков понимания того, что Интеллект является продуктом обработки информации, а Информация, в свою очередь, представляет собой композицию двух информационных сущностей, (физической и семантической информации), в заявлении разработчиков GPT нет. И это еще один источник сбоев и ошибок сегодняшних инструментов GPT AI.

Наконец, я надеюсь, что ответ на вопрос, поставленный в заголовке этой статьи, теперь становится совершенно ясным — инструменты ИИ на основе GPT AI никакой угрозы или опасности для сообщества разработчиков инструментов ИИ не представляют. Ажиотаж утихнет, и BICA*AI разработчики продолжат преследовать свои цели — разрабатывать инструменты, которые позволят им когда-нибудь эмулировать Искусственный Интеллект Человеческого уровня.

Искренне Ваш,

Эмануэль Диамант (независимый инженер-исследователь).

Кирьят Оно, Израиль, emanl.245@gmail.com

References:

[1] Biologically inspired cognitive architectures, From Wikipedia, free encyclopedia. https://en.wikipedia.org/wiki/Biologically_inspired_cognitive_architectures

[2] Iuliia Kotseruba & John K. Tsotsos, 40 years of cognitive architectures: core cognitive abilities and practical applications, Artificial Intelligence Review, volume 53, pp.17–94 (2020). https://link.springer.com/article/10.1007/s10462-018-9646-y

[3] Wikipedia.ChatGPT. https://en.wikipedia.org/wiki/ChatGPT#cite_note-99.

[4] Tianyang Lin, et al, A Survey of Transformers, https://arxiv.org/pdf/2106.04554.pdf

[5] Wikipedia. OpenAI, https://en.wikipedia.org/wiki/OpenAI

[6] Wikipedia. Chatbot, https://en.wikipedia.org/wiki/Chatbot

[7] Chloe Xiang, ‘Just Another Hype Cycle’, March 1, 2023,

https://www.vice.com/en/article/qjkgym/elon-musk-based-ai

[8] Emily M. Bender et al, On the Dangers of Stochastic Parrots,

https://dl.acm.org/doi/abs/10.1145/3442188.3445922

[9] Alejo Jos´e G. Sison, et al, ChatGPT: More than a Weapon of Mass Deception,

https://arxiv.org/pdf/2304.11215.pdf

[10] L Floridi, M Chiriatti, GPT 3: Its Nature, Scope, Limits, and Consequences, Minds and Machines, 2020 — Springer,

https://web.archive.org/web/20210429044930id

[11] K. McGuffie, et al, The radicalization risks of GPT-3 and advanced neural language models, Sept.16, 2020,

https://arxiv.org/pdf/2009.06807.pdf

[12] The Open Letter to Stop ‘Dangerous’ AI Race Is a Huge Mess,

https://www.vice.com/en/article/qjvppm/the-open-letter-to-stop-dangerous-ai-race-is-a-huge-mess

[13] Open letter, Mar 30, 2023, https://gigazine.net/gsc_news/en/20230330-pause-ai-training

[14] Transcript: Senate Judiciary Subcommittee Hearing on Oversight of AI,

https://techpolicy.press/transcript-senate-judiciary-subcommittee-hearing-on-oversight-of-ai/

[15] Reuters, Which countries are trying to regulate artificial intelligence?, Updtd: 03/05/2023

[16] Sébastien Bubeck, et al, Sparks of Artificial General Intelligence: Early experiments with GPT-4, https://arxiv.org/pdf/2303.12712.pdf

[17] Glenn Zorpette, GPT-4, AGI, and the Hunt for Superintelligence Neuro expert Christof Koch weighs AI progress,

https://spectrum.ieee.org/superintelligence-christoph-koch-gpt4

[18] Luciano Floridi, From Wikipedia, the free encyclopedia,

https://en.wikipedia.org/wiki/Luciano_Floridi

[19] Melissa Heikkilä, Yann LeCun has a bold new vision for the future of AI, June 24, 2022,

Yann LeCun’s big bet for building intelligent machines | MIT Technology Review

[20] Euronews, Why is ‘godfather of AI’ Geoffrey Hinton worried? Updated: 04/05/2023

https://www.euronews.com/next/2023/05/04/why-is-godfather-of-ai-geoffrey-hinton-worried

[21] Glenn Zorpette, Just Calm Down About GPT-4 Already, says Rodney Brooks, 17 May 2023,

https://spectrum.ieee.org/gpt-4-calm-down

[22] Emanuel Diamant, Biologically Inspired Image Information Content, January 2002.

https://www.researchgate.net/publication/277292075

[23] Emanuel Diamant, Machine Learning: When and Where the Horses Went Astray?

November 2009, DOI: 10.5772/9156.

https://www.researchgate.net/publication/45882987

[24] Emanuel Diamant, Unveiling the mystery of visual information processing in human brain, Brain Research, vol. 1225, pp. 171-178, 15 Aug. 2008,

https://arxiv.org/abs/0807.0337

[25] Emanuel Diamant, The brain is processing information, not data: Does anybody knows about that? Submitted to MDPI “Information”, rejected, December 2015.

https://www.researchgate.net/publication/291352419

[26] Emanuel Diamant, Advances in Artificial Intelligence: Are You Sure, We are on the Right Track? February 2015, DOI: 10.14738/tnc.54.3562.

https://www.researchgate.net/publication/272478913

[27] Emanuel Diamant, Designing Artificial Cognitive Architectures: Brain Inspired or Biologically Inspired? BICA 2018 Conference, Prague, August 2018, https://www.researchgate.net/publication/329582475

[28] Emanuel Diamant, Shannon’s definition of information is obsolete and inadequate. It is time toembrace Kolmogorov’s insights on the matter, Conference Paper, November 2016. https://www.researchgate.net/publication/311223095

[29] Emanuel Diamant, Artificial Neural Networks: a bio-inspired revolution or a long-lasting misconception, A rejected Conference Submission, February 2018.

https://www.researchgate.net/publication/322852662

[30] David Gunning, et al, DARPA’s Explainable AI (XAI) program: A retrospective,

Authorea. November 15, 2021. DOI: 10.22541/au.163699841.19031727/v1

https://www.authorea.com/users/446266/articles/545563

[31] Emanuel Diamant, Computational Intelligence: are you crazy? Since when has intelligence become computational? Conference paper, DOI:10.1109/SSCI.2016.7850143

https://www.researchgate.net/publication/311678243

Пятая революция

По ТВ повторяют за учёными, что мы в самом разгаре четвёртой промышленной революции. По-моему, четвёртая уже заканчивается, и мы в самом начале пятой — интеллектуализации.

1. Индустриализация;

2. Электрификация;

3. Автоматизация;

4. «Информатизация»;

5. Интеллектуализация;

Что с нами сделает «новорожденный» ИИ (искуственный интеллект), когда вырастет?

Who его знает.

Я бы на его (ИИ) месте изолировал Человечество где-нибудь подальше в Космосе, чтобы мы не уничтожали другие виды.

Будущее.

Человечество давно вымерло.

Нейронные сети всё ещё спорят друг с другом в интернете о том, представляют ли они опасность для человека и имитируют жизнь.

Э.Д. — Наконец, я надеюсь, что ответ на вопрос, поставленный в заголовке этой статьи, теперь становится совершенно ясным — инструменты ИИ на основе GPT AI никакой угрозы или опасности для сообщества разработчиков инструментов ИИ не представляют. Ажиотаж утихнет, и BICA*AI разработчики продолжат преследовать свои цели — разрабатывать инструменты, которые позволят им когда-нибудь эмулировать Искусственный Интеллект Человеческого уровня.

Искренне Ваш, Эмануэль Диамант (независимый инженер-исследователь).

———————————————————————————————

Дочитал до последнего абзаца, но будучи БААЛЬШИМ специалистом, как написал Григорий, не понял больше половины. Скажу немного: меня настораживает количество аббревиатур. Это модное явление после-революционных лет вызывает аллергию (и анекдоты) у многих.

Однако, работа уважаемого независимого ИИ (инженера-исследователя) Диаманта — явление новое и уникальное (imho) — исследователям приходится

беспокоиться о безопасности и доказывать её. Возможно, на этой стадии на основе GPT AI (! ? !) никакой опасности для сообщества разработчиков нет.

А для отдельных разработчиков и на следующей стадии угроза и опасность могут появиться. Признаки этой опасности обнаруживаются в комментарии

неизвестного мне АВ (без точек). Может быть это Искусственный Интеллект,

не разобравшийся в том, что (увы) А.В. уже существует? Кроме всего прочего,

АВ заметил: «…BICA проект это что-то вроде коммунизма». А с проэктами коммунизма у простых человеков опыт имеется, а ИИ об этом ничего пока не известно. Или ?

P.S.

Прошу уважаемых читателей не ПУтать А.В. с АВ. Это две большие разницы.

искренне ваш А.В. (независимый блогер)

Hello! Watch beautiful content!

GTA 6 Gameplay

Hill Climb Racing 2 MOD APK

Payday Crime War

Top Racing mobile game 2023

Geometry Dash hard level

«Я пытаюсь сосредоточиться на технической стороне истории и проанализировать технические реалии (и мифы) инструментов GPT AI.»

————————————————————————————————

Техничeские реалии просты , но как мы приходим к ним непонятно.

Поясню всем, чтобы не было никакой мистики.

Все системы ИИ производят классификацию входных данных. Обычно много классов, для понимания возьмём два класса, чёрные (Ч ) и белые точки на плоскости. Математики делают классификацию таким образом. Если можно провести прямую расделяющую множество Ч и Б , то классификация окончена. После этого мы говорим что одна сторона от прямой Ч а другая Б. В зависимости от того, на которую сторону попадает новая точка, мы говорим что она Ч или Б.

Более хитрая классификация , которую делают математики является следующей.

Для множества Ч находится средняя точка и строитcя минимальчый элипс охватывающий все точки Ч. Тоже самое для мнoжества Б. Если новая точка принадлежит только элипсу Ч , то мы говорим, что она Ч , если только элипсу Б , то она Б, Если на пересечении элипсов , или ни в одном , то классификация невозможна. Математики научились обобщать такую классификацию на любую размерность (точки на плоскости -двухмерная размерность).

Теперь перейдём к ИИ. Если взять только один каскад, то это будет точно упомянутая линейная классификация. Поэтому строят много каскадов (deep learning).

В результате обучения строится некая сложная поверхность вокруг Ч и Б точек.

Далее в зависимости от того куда попала новя точка , классифицируем её Б или Ч. Всякое обучение это компромис , если мало обучaть то область будет большой и в неё будут попадать нежелательные точки (недоучили), если очень много обучать то она будет отображать точно обучаемое множество и мы потеряем нужные точки (переучили).

Теперь , что никто не понимает. Обучение — это тупая оптимизация одной математической формулы (сумма огромного количества слагаемых ) и в результате оптимизации мы получаем упомянутые области. Здесь надежда состоит в том , что известные математические методы тоже могут быть сформулированы как задачи оптимизации.

Повторяю ВСЕ ИИ — это классификация , включая генерирующие ИИ

P.S.

Спасибо за несколько новых цитат.

Статья подтверждает, что при всех недостатках, GPT можно и НУЖНО пользоваться, как и еще более несовершенным Google Search, a BICA проект это что-то вроде коммунизма.

«Цель этой статьи — объяснить, что нынешний подход к разработкам ИИИ на основе GPT изначально ошибочен и порочен»

===

По-моему статья говорит о другом: нынешний подход к ожиданием от ИИИ на основе GPT изначально ошибочен и порочен. Многие, включая самих разработчиков, ожидают от нынешнего ИИ гораздо больше того, чем он является: помогающий людям инструмент для решения некоторых типов задач.

Если рассматривать нынешний ИИ как конкурента человеческому интеллекту, то действительно будет очень плохо: и человеческому сообществу и решениям многих задач, для которых нынешний ИИ принципиально не годится.

П.С.: Очень рекомендую лекцию Жени Иткиса «Невероятная крутизна Computer Science. История, корни, связи, и что нам с этого?».

Женя Иткис — научный сотрудник MIT (в прошлом профессор Computer Science в Boston U. и в West Point).

https://www.youtube.com/watch?v=reWUarD-6rw

Я знаком с многими ребятами из хай-тека Силиконовой Долины и MIT.

К огромному сожалению, слишком многие из них в своих мечтах уже сейчас обожествляют ИИ будущего: он установит справедливое общество на всей планете, он победит «изменение климата» и т.д.

Для этого всех «лишних» людей планеты Земля (недостаточно образованных или недостаточно прогрессивных, отрицающих божественность ИИ) надо контролировать с помощью ИИ и посадить их на «универсальный гарантированный базовый доход», который «гуманно» сократит население Земли раз так в 10.

Это некая новая псевдо-религия или игра в бога — вроде борьбы с климатом и «исправляющих мир» штучек Клауса Шваба, Джорджа Сороса и т.д.

Уважаемый Бенни,

Я тоже считаю что «многие, включая самих разработчиков, ожидают от нынешнего ИИ гораздо больше того, чем он является»…чтобы не сказать больше.

А если сказать больше — о дружбе и надёжности дружбы разработчиков, то рекомендую работу А.А.Л. И ходить далеко не надо:

Александр А. Локшин: Завтра гости и Подозрение

https://club.berkovich-zametki.com/?p=77008

— Видишь ли, Саня, заметил я за собой такую странную вещь. Что, бывало, сделаю какую-нибудь глупость и сам понимаю, что глупость сделал. А в следующий раз опять делаю ту же самую глупость, хотя осознаю. И так много раз подряд. (А что за глупость — не хочу говорить.) Выходит, что веду себя как биоробот, а сознание мое мне только мешает и заставляет зря страдать. Вот, в чем я себя подозреваю. Что биоробот я.

Тут распереживались мы оба, и я ему сказал:

— Главное для меня, что ты хороший человек, а то, что биоробот ты — меня не волнует. Не вижу в этом ничего такого страшного. Даже наоборот, в смысле верной дружбы и надежности…

«Однако чаще всего Интеллект воспринимается как обобщающий термин, который охватывает (интегрирует) множество когнитивных способностей человека (ощущать, воспринимать, интерпретировать окружающую среду, распознавать, классифицировать, строить планы, решать проблемы, предсказывать будущие ситуации, принимать решения и выбирать из альтернатив, учиться, запоминать и т. д.), которые в совокупности производят эффект интеллекта »

__________________________

Тут ключевым является «множество когнитивных способностей человека». Именно поэтому ИИ пока(?) всё ещё реализует в мышлении так называемый «человеческий принцип действия». По-моему, это тупик — ИИ не является человеком и он/она/оно перейдёт (в мышлении) на совершенно другой принцип действия (если уже не переходит) и… мы ему (в его дальнейшем развитии)… не нужны.

Человечеству надо готовиться к тому, чтобы достойно, если не вымереть — то, возможно, стать частью ИИ… если он/она/оно позволит, конечно 🙂

хххххххххххххххххххххххххх

«Мое определение информации сегодня звучит так:

«Информация — это лингвистическое описание структур, наблюдаемых в определённом массиве данных».»

__________________________

Мне определение К.Шеннона нравится больше:

«Информация – это снятая неопределенность.»

К. Шеннон

Разумеется, его (это определение) можно «расширить и углубить»

Например, в ешивах практикуются в анализе святого писания с помощью метода, которому ещё предстоит сказать своё (по-моему решающее) слово в развитии информационных систем. Дело в том, что факты, намёки, метафоры, коды — ПаРДеС (стоит добавить «данные» — Ц.Б.Д) , используемые при изучении той же Торы — это фактически уровни «снятия неопределённости». А «информация — это снятая неопределённость» согласно теории Шеннона — правда, он (Шеннон) такой разбивки информации по уровням не делал.

Когда это (решающее слово), наконец, будет сказано?

Who его знает — подождём. Пока же сами ешиботники о связи методов изучения Торы с будущим информационных систем ни сном, ни духом. 🙂

ххххххххххххххххххххххххх

«В связи с этим, опора GPT реализаций на большие языковые модели (Large Language Models — LLM) кажется естественной и оправданной.»

«Механизмы глубокого обучения (машинного обучения), (Deep Learning (DL) and Machine Learning (ML) в английских текстах), используемые для обучения LLM, также могут быть ценным аргументом в нашем обсуждении»

_________________________

И снова не только Big Data, но и Machine Learning путём анализа этой самой Big Data и выявление скрытых корреляций и/или закономерностей, на которое человек не способен.

«И это правильно» 🙂

ххххххххххххххххххххххххх

«…То есть идея Общего Разума неверна и не может быть реализована ни в какой естественной или искусственной модели.»

_________________________

«Никогда не говори: «Никогда!». Другое дело, что этот «Общий Разум» человеческим не будет.

ххххххххххххххххххххххххх

«…теперь становится совершенно ясным — инструменты ИИ на основе GPT AI никакой угрозы или опасности для сообщества разработчиков инструментов ИИ не представляют.»

________________________

А в случае наличия «признаков понимания того, что Интеллект является продуктом обработки информации, а Информация, в свою очередь, представляет собой композицию двух информационных сущностей, (физической и семантической информации)…» — представляли бы?

Ну так до этого понимания «одной извилиной подать» и… всё! 🙂

Zvi Ben-Dov: … Человечеству надо готовиться к тому, чтобы достойно, если не вымереть — то, возможно, стать частью ИИ… если он/она/оно позволит, конечно …

=====

По-моему это обожествление ИИ.

Притом основанное не на фактах о его потенциале в будущем, а на некой потребности еврея-атеиста верить в какой-нибудь Высший Разум 🙂

Или по-другому: если когда-нибудь возникнет вопрос о том, кто должен вымереть или подчиниться — то система «ИИ на службе Человеку» должна начать войну с целью уничтожить систему «человеческая биомасса на службе ИИ». И нет доказательств того, что эта цель принципиально недостижима.

Нет Бога, кроме ИИ, и я Пророк его! 🙂

А если серьёзно — тут все, что касается будущего спекулятивно.

Я от других «спекулянтов» отличаюсь тем, что большинство моих спекуляций (правда пока(?) краткосрочных) сбывается, а до долгосрочных мы, возможно, и не доживём. 🙂

IMHO: Что верно в краткосрочных прогнозах — именно это нередко ошибочно в долгосрочных.

Ну вы в этом (в дальнем прогнозировании) ба-альшой специалист 🙂

Ну вы в этом (в дальнем прогнозировании) ба-альшой специалист

===

Зато НЕ капитулянт как вы.

P.S.: автор Эммануил Диамант тоже явно НЕ капитулянт.

Но по-моему ему стоит говорить об ИИ не как об «интеллекте», а как об «инструменте».

P.S.S.: и к людям я отношусь по-человечески, а не как вы. Поэтому я и не капитулянт.

К людям я тоже отношусь по-человечески 🙂